Deep Web: Unterschied zwischen den Versionen

KKeine Bearbeitungszusammenfassung |

Keine Bearbeitungszusammenfassung |

||

| Zeile 6: | Zeile 6: | ||

Um ein Teil des Deep Web zu werden muss man also für den Ausschluss der gewünschten Webseite aus den Indizierungsmechanismen der Suchmaschinen sorgen. „Eine manuelle Maßnahme, um zum Deep Web zu gehören, wird mit Hilfe des Noindex Elements im <head> Bereich des Quelltextes erreicht: <me-ta name=“robots“ content=“noindex“>. Daneben kann in der robots.txt Datei mittels des Disavow Be-fehls spezifiziert werden, welche Inhalte von Spidern ignoriert werden sollen. Damit können nicht nur Unterseiten, sondern auch Bilder, Videos und PDFs aus dem Index ausgeschlossen werden. Weiterhin können Crawlern der Zugriff verweigert werden, indem eine Aktion ausgeführt werden muss, wie zum Beispiel die Eingabe eines Passworts, um eine Seite zu besuchen.“ Auch kann eine Website ungewollt Teil des Deep Webs werden, wenn der Ausschluss von der Suchmaschine selber ausgeht. Dies kann bei Verstößen gegen die Richtlinien der Suchmaschinen, z.B. Slow Death durch Duplicate Content, gesche-hen oder durch Anordnung von Staatlichen Autoritäten. | Um ein Teil des Deep Web zu werden muss man also für den Ausschluss der gewünschten Webseite aus den Indizierungsmechanismen der Suchmaschinen sorgen. „Eine manuelle Maßnahme, um zum Deep Web zu gehören, wird mit Hilfe des Noindex Elements im <head> Bereich des Quelltextes erreicht: <me-ta name=“robots“ content=“noindex“>. Daneben kann in der robots.txt Datei mittels des Disavow Be-fehls spezifiziert werden, welche Inhalte von Spidern ignoriert werden sollen. Damit können nicht nur Unterseiten, sondern auch Bilder, Videos und PDFs aus dem Index ausgeschlossen werden. Weiterhin können Crawlern der Zugriff verweigert werden, indem eine Aktion ausgeführt werden muss, wie zum Beispiel die Eingabe eines Passworts, um eine Seite zu besuchen.“ Auch kann eine Website ungewollt Teil des Deep Webs werden, wenn der Ausschluss von der Suchmaschine selber ausgeht. Dies kann bei Verstößen gegen die Richtlinien der Suchmaschinen, z.B. Slow Death durch Duplicate Content, gesche-hen oder durch Anordnung von Staatlichen Autoritäten. | ||

Quellen: | Quellen:<br> | ||

https://www.advidera.com/glossar/deep-web/<br> | https://www.advidera.com/glossar/deep-web/<br> | ||

https://www.ub.uni-bielefeld.de/biblio/search/help/invisibleweb.htm<br> | https://www.ub.uni-bielefeld.de/biblio/search/help/invisibleweb.htm<br> | ||

https://oedb.org/ilibrarian/invisible-web/ | https://oedb.org/ilibrarian/invisible-web/ | ||

Version vom 2. August 2019, 12:36 Uhr

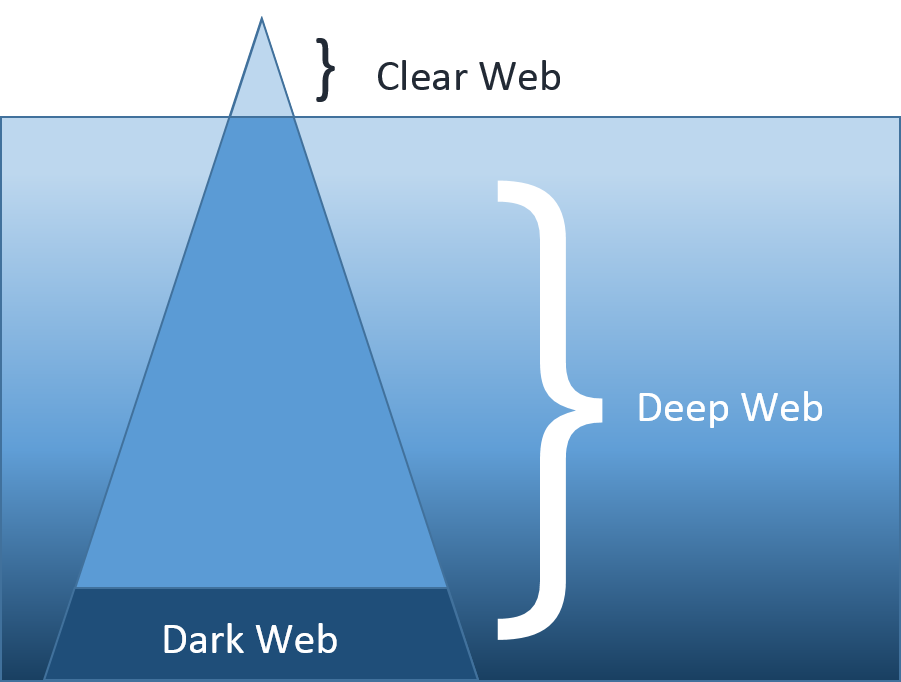

Das Deep Web bezeichnet die Gesamtheit der im Internet erreichbaren Daten und Dienste, welche nicht durch Suchmaschinen wie Google indexiert wurden. Dies umfasst auch das Dark Net welches aber nur einen kleinen Teil vom Deep Web ausmacht. Der Großteil des Deep Web sind Datenbanken, Back End und Admin Infrastruktur, geschützte Webseiten und private Fileshares. „Die Größe des Deep Webs kann nicht eindeutig definiert werden. Eine Studie aus dem Jahre 2001 argumentierte, dass das Deep Web bis zu 550 Mal größer ist als das Visible Web. Da diese Studie schon mehr als ein Jahrzehnt alt ist, wird an-genommen, dass dieser Wert auch heute noch exponentiell weiter steigt.“ Eine genaue Größe des Deep Web lässt sich nur schwer schätzen, sie dürfte aber im Zettabyte-Bereich angesiedelt sein.

Das Deep Web wird oft mit dem Dark Net verwechselt. Dies liegt an der Namensähnlichkeit aber auch der inhaltlichen Nähe. Das Dark Net (oder auch Dark Web bezeichnet) ist jedoch ein spezielles Peer-to-Peer Overlay-Netzwerk, welches mit dem Spezialbrowser TOR (the Onion Router) zugänglich ist. Dieses auf absolute Anonymität ausgelegte Netzwerk ist zwar Teil des Deep Webs, allerdings ein vergleichbar kleiner Teil. Um ein Teil des Deep Web zu werden muss man also für den Ausschluss der gewünschten Webseite aus den Indizierungsmechanismen der Suchmaschinen sorgen. „Eine manuelle Maßnahme, um zum Deep Web zu gehören, wird mit Hilfe des Noindex Elements im <head> Bereich des Quelltextes erreicht: <me-ta name=“robots“ content=“noindex“>. Daneben kann in der robots.txt Datei mittels des Disavow Be-fehls spezifiziert werden, welche Inhalte von Spidern ignoriert werden sollen. Damit können nicht nur Unterseiten, sondern auch Bilder, Videos und PDFs aus dem Index ausgeschlossen werden. Weiterhin können Crawlern der Zugriff verweigert werden, indem eine Aktion ausgeführt werden muss, wie zum Beispiel die Eingabe eines Passworts, um eine Seite zu besuchen.“ Auch kann eine Website ungewollt Teil des Deep Webs werden, wenn der Ausschluss von der Suchmaschine selber ausgeht. Dies kann bei Verstößen gegen die Richtlinien der Suchmaschinen, z.B. Slow Death durch Duplicate Content, gesche-hen oder durch Anordnung von Staatlichen Autoritäten.

Quellen:

https://www.advidera.com/glossar/deep-web/

https://www.ub.uni-bielefeld.de/biblio/search/help/invisibleweb.htm

https://oedb.org/ilibrarian/invisible-web/